pravděpodobnosti jejich výskytu,

přičemž musí platit:

pravděpodobnosti jejich výskytu,

přičemž musí platit:  pak množství informace nutné k odstranění neurčitosti o stavu systému

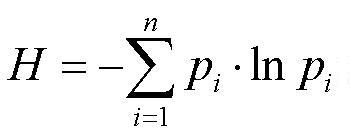

(tzv. Shannonova entropie) je dáno následujícím vzorcem:

pak množství informace nutné k odstranění neurčitosti o stavu systému

(tzv. Shannonova entropie) je dáno následujícím vzorcem:

Pojem „informace“ se často užívá v běžné řeči, ale je problém ji definovat. Otázka „Co to je informace?“ je dosti těžká.

Nyní několik definic pojmu informace:

Informace je zpráva, která snižuje neznalost (neurčitost) o stavu systému.

Informace je název pro obsah toho,

co si vyměňujeme s vnějším světem, když se mu přizpůsobujeme a působíme na něj svým přizpůsobováním (Norbert Wiener).

Informace tedy není to, co si vyměňujeme, ale obsah toho, co si vyměňujeme.

Člověk vnímá svět skrze informace.

Význam informace zdůraznila kybernetika (věda o řízení).

Informace je zpráva, která snižuje neznalost (neurčitost) o stavu systému.

Systém má n možných stavů,

pravděpodobnosti jejich výskytu,

přičemž musí platit:

pravděpodobnosti jejich výskytu,

přičemž musí platit:  pak množství informace nutné k odstranění neurčitosti o stavu systému

(tzv. Shannonova entropie) je dáno následujícím vzorcem:

pak množství informace nutné k odstranění neurčitosti o stavu systému

(tzv. Shannonova entropie) je dáno následujícím vzorcem:

Shannonův vzorec

Tato kvantitativní teorie informace vychází z předpokladu, že počet stavů systému je známý a konečný, že jsou navíc známy pravděpodobnosti výskytů stavů.

Entropie je míra neurčitosti náhodného pokusu.

Je to též množství informace nutné k odstranění neurčitosti.

Kvantitativně je dána Shannonovým vzorcem.

Jsou-li všechny stavy stejně pravděpodobné, tj. pravděpodobnosti jsou rovnoměrně rozděleny,

je entropie nejvyšší.

Má-li jeden stav pravděpodobnost 1, ostatní stavy pravděpodobnost 0, je entropie nejnižší.

Vzpomeňme si na soutěžní pořad "Chcete být milionářem" .

Soutěžící dostal otázku, dále 4 možné odpovědi (A, B, C, D).

Úkolem soutěžícího bylo vybrat tu správnou odpověď. Pokud si nebyl jist, mohl použít (jednou za hru) nápovědu publika.

Soutěžící se dozvěděl, kolik % z přítomných hlasovalo pro jednotlivé možnosti.

Pokud jedna možnost výrazně převažovala nad ostatními, nápověda publika pomohla

(Shannonova entropie dala nízkou hodnotu, míra neurčitosti se snížila).

Pokud to bylo vyrovnané, nápověda publika moc nepomohla

(Shannonova entropie dala vysokou hodnotu, míra neurčitosti zůstala vysoká).

Čím více je to vyrovnané, tím je Shannonova entropie vyšší. Přesvědčte se o tom

Všimněme si ještě jisté analogie s termodynamickou entropií.

Setkají-li se tělesa o různých teplotách, bude přecházet teplo z teplejšího tělesa na chladnější,

až se teploty těles vyrovnají. Tu dosáhne entropie maxima a tepelná výměna ustane.